KI Beschleuniger: Desktop vs. Embedded

über

Künstliche Intelligenz (KI) entwickelt sich rasant weiter, und die Wahl des richtigen KI-Beschleunigers ist entscheidend. Im Folgenden werden einige wichtige Beschleuniger vorgestellt und ihre Funktionen und Leistung verglichen, um eine fundierte Entscheidung für Ihre speziellen KI-Anforderungen zu treffen.

Der Bedarf an KI-Beschleunigern

Warum brauchen wir KI-Beschleuniger? Sicherlich würde jede CPU oder jeder Mikrocontroller genau die Berechnungen durchführen, die auch ein KI-Beschleuniger durchführen könnte. Allzweck-CPUs und Mikrocontroller sind jedoch für eine breite Palette von Aufgaben ausgelegt, aber meist nicht sehr effizient bei spezifischen KI-bezogenen Berechnungen.

Ein KI-Beschleuniger ist eine spezialisierte Hardwarekomponente zur Beschleunigung von Aufgaben der künstlichen Intelligenz, die sich in erster Linie auf die Inferenzphase konzentriert, in der KI-Modelle auf der Grundlage neuer Daten Vorhersagen machen. Im Gegensatz zu Allzweckprozessoren sind KI-Beschleuniger für die Durchführung umfangreicher Matrixoperationen und Parallelverarbeitung optimiert, die für Aufgaben wie Bilderkennung, Verarbeitung natürlicher Sprache und andere Anwendungen des maschinellen Lernens unerlässlich sind. Dadurch sind sie im Vergleich zu Standard-CPUs wesentlich schneller und effizienter bei der Durchführung dieser speziellen Berechnungen.

Im Fortschreiten der KI gewinnt Edge Computing - die lokale Verarbeitung von Daten auf kleinen Geräten statt auf zentralen Cloud-Servern - zunehmend an Bedeutung. Dieser Wandel verbessert die Echtzeit-Reaktionsfähigkeit, den Datenschutz und die Gesamteffizienz. Um die Anforderungen zu erfüllen, wurden verschiedene Edge-KI-Beschleuniger sowohl für eingebettete Systeme als auch für PCs entwickelt.

Ob Sie leistungsstarke Lösungen für komplexe Aufgaben oder leichtgewichtige Geräte für Echtzeit-Außeneinsätze benötigen, die Wahl des richtigen Tools für Ihre spezifischen Anforderungen kann schwierig sein. Deshalb geben wir einen Überblick über einige der führenden Edge-KI-Beschleuniger, wobei wir ihre Funktionen, typische Anwendungen und Leistungsfähigkeit hervorheben.

Warum dieser Vergleich?

Für Anwendungen wie die Transkription von Sprache in Text (zum Beispiel mit Whisper ) und die automatische Videobearbeitung und die Klassifizierung von archivierten Videoaufnahmen muss ich oft große Datenmengen verarbeiten. Für diese Aufgaben sind Lösungen auf PCs mit leistungsstarken GPUs wie meine NVIDIA RTX 4070 aufgrund ihrer Rechenleistung und Flexibilität unverzichtbar. Für Echtzeiterkennung im Feld oder in industriellen Umgebungen sind dagegen eingebettete Lösungen wie das Raspberry Pi AI-Kit oder das Coral-Dev-Board aufgrund ihrer Kompaktheit und ihres geringeren Energiebedarfs praktischer. Dieser Vergleich soll helfen, die besten Tools für verschiedene Szenarien zu bestimmen.

Eingebettete Edge AI-Beschleuniger

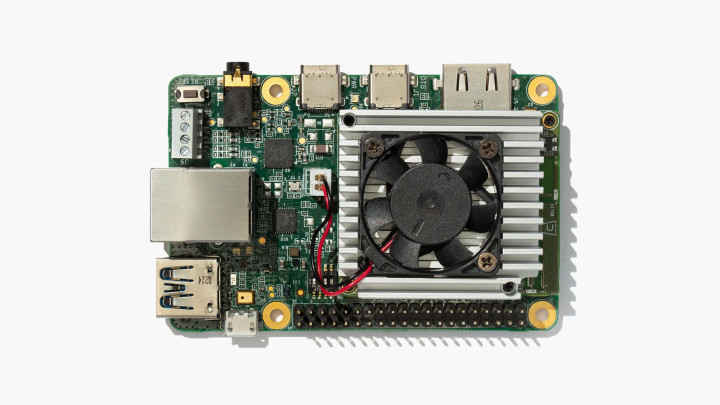

Raspberry Pi AI-Kit mit integriertem Hailo-8L

Das kürzlich vorgestellte Raspberry Pi AI-Kit verbindet den KI-Beschleuniger Hailo-8L mit dem Raspberry Pi 5 und ermöglicht damit leistungsstarke KI-Funktionen in einem kostengünstigen, kompakten Formfaktor. Es ist eine erschwingliche Lösung, um KI verschiedenen Raspberry-Pi-Projekten hinzuzufügen.

Der KI-Beschleuniger Hailo-8L wird in den M.2-Steckplatz des mitgelieferten Raspberry-Pi-M.2-HAT+ gesteckt (Bild 1). Dort bietet er 13 Tera Operationen pro Sekunde (TOPS) und eignet sich damit für Aufgaben wie Objekterkennung in Echtzeit, semantische Segmentierung, Posenabschätzung zur Erkennung von Gesten und Mimik. Der niedrige Strombedarf des Kits ist ideal für batteriebetriebene Anwendungen, und seine kompakten Abmessungen lassen sich gut mit dem offiziellen Raspberry-Pi-Kamerazubehör kombinieren. Obwohl das Kit nicht so leistungsfähig ist wie einige High-End-NPUs, eignet es sich perfekt für leichte KI-Aufgaben, Bildungsprojekte und Hobbyanwendungen.

Coral Dev-Board

Das 2019 von Coral vorgestellte Dev-Board wurde entwickelt, um TensorFlow-Lite-Modelle effizient als eigenständige Lösung auszuführen. In einem Raspberry-Pi-ähnlichen Formfaktor (Bild 2) verfügt es über einen Edge-TPU-Coprozessor, der 4 TOPS liefert. Das Board eignet sich hervorragend zur Bildklassifizierung, Objekt- und Spracherkennung und ist damit ideal für IoT-Anwendungen. Die geringe Stromaufnahme ist ein großer Vorteil, insbesondere für eingebettete Systeme. Allerdings ist das Dev-Board in erster Linie auf TensorFlow-Lite-Modelle beschränkt und bietet im Vergleich zu einigen anderen Beschleunigern weniger Rechenleistung. Trotzdem lässt es sich nahtlos in die Cloud-Dienste von Google integrieren und bietet eine effiziente Leistung für grundlegende KI-Anwendungen in eingebetteten Systemen.

Coral USB-Beschleuniger

Wenn Sie sich bereits für eine Computing-Plattform entschieden haben und noch etwas externe KI-Leistung benötigen, bietet sich der USB-Accelerator von Coral an. Dieses kompakte Gerät, das ungefähr die Größe eines Standard-USB-Sticks hat (Bild 3), bringt die Leistung der Edge-TPU von Google über eine USB-3.0-Verbindung auf jeden kompatiblen Computer. Der Beschleuniger bietet eine Leistung von 4 TOPS und nimmt dabei eine Leistung von nur 2 W auf. Der USB-Beschleuniger ist ideal für Entwickler, die bestehende Systeme mit KI-Funktionen ausstatten oder Prototypen von Edge-KI-Anwendungen entwickeln möchten, ohne sich auf ein komplettes Entwicklungsboard festlegen zu müssen. Er eignet sich hervorragend für Aufgaben wie Bildklassifizierung und Objekterkennung und ist damit ein vielseitiges Werkzeug für KI-Experimente und kleine Implementierungen.

NVIDIA Jetson

Bei der Jetson-Reihe von NVIDIA handelt es sich um eine Reihe von Embedded-Computing-Boards für KI-Anwendungen im Edge-Bereich. Dieses Ökosystem umfasst mehrere Produkte für unterschiedliche Leistungsanforderungen und Anwendungsfälle:

- Jetson Nano: Das Einsteigermodell, geeignet für kleinere KI-Projekte und Prototyping

- Jetson Xavier NX: Eine Mittelklasse-Option mit deutlich mehr Leistung als der Nano

- Jetson AGX Xavier: Ein Hochleistungsmodul für anspruchsvolle KI-Anwendungen

- Jetson AGX Orin: Das neueste und leistungsstärkste Modul der Reihe für erweiterte Robotik und autonome Maschinen.

Diese Module variieren in ihrer Rechenleistung und reichen von 0,5 TOPS beim Nano bis über 200 TOPS beim AGX Orin.

Alle Jetson-Geräte laufen auf dem JetPack-SDK von NVIDIA, das Bibliotheken für Deep Learning, Computer Vision, Accelerated Computing und Multimedia-Verarbeitung enthält. Diese gemeinsame Software-Umgebung ermöglicht eine einfachere Skalierung und Bereitstellung für die gesamte Jetson-Familie.

Die Jetson-Familie eignet sich für eine Vielzahl von Anwendungen wie Robotik, Drohnen, intelligente Videoanalyse und tragbare medizinische Geräte. Ihre Skalierbarkeit macht sie zu einer vielseitigen Wahl für Unternehmen, die KI-Anwendungen über verschiedene Leistungsstufen hinweg entwickeln und einsetzen möchten.

Das 2019 eingeführte Einsteigermodell Jetson Nano (Bild 4) brachte KI-Rechenfähigkeiten in kleinen und preiswerten Formfaktoren. Es verfügt über einen Maxwell-Grafikprozessor mit 128 Kernen, eine Quad-Core-ARM-Cortex-A57-CPU und 4 GB RAM und liefert 472 GFLOPS (0,47 TOPS). Der Jetson Nano ist für kleine, aber anspruchsvolle KI-Aufgaben in eingebetteten Systemen gut geeignet. Er kann mehrere neuronale Netze gleichzeitig verarbeiten, was ihn zu einer flexiblen Option für verschiedene KI-Anwendungen macht. Allerdings ist seine Stromaufnahme höher als bei anderen eingebetteten Optionen, und er hat einen größeren Formfaktor.

Der Nano ist ein KI-Modul mit einem 260-poligen Edge-Verbinder, so dass es nicht möglich ist, ihn eigenständig zu verwenden, ohne ihn in etwas hineinzustecken. Als Einsteiger sollten Sie mit einem Dev-Kit beginnen, das Sie unter Passende Produkte finden. Weitere Informationen zu den anderen Boards der Jetson-Reihe finden Sie auf der Vergleichsseite von NVIDIA unter .

Intel Neural Compute Stick 2

Der Neural Compute Stick 2 (NCS2), der 2018 von Intel vorgestellt wurde, ist ein weiterer „portabler“ USB-basierter KI-Beschleuniger (Bild 5). Er ist mit der hauseigenen Movidius-Myriad-X-VPU ausgestattet und bietet eine Leistung von etwa 1 TOPS. Er ist ideal für KI-Prototyping, Forschung und die Erweiterung bestehender PCs mit KI-Funktionen. Seine Portabilität und Benutzerfreundlichkeit machen ihn zu einer beliebten Wahl für Entwickler und Forscher. Allerdings ist er für die Stromversorgung und Datenverarbeitung auf einen Host-PC angewiesen und bietet im Vergleich zu High-End-GPUs eine geringere Rechenleistung.

PC-basierte Edge-KI-Beschleuniger

NVIDIA-GPUs

Die oben erwähnte GPU RTX 4070 von NVIDIA gehört zur RTX 40-Serie, die 2022 auf den Markt kam, und ist ein Kraftpaket sowohl für Spiele als auch für professionelle KI-Anwendungen. Dieser High-End-Grafikprozessor, der auf Grafikkarten verschiedener Anbieter erhältlich ist, verfügt über 29,8 TFLOPS (entsprechend 29.800 GFLOPS) und 12 GB GDDR6-Speicher. Die GPU eignet sich perfekt für das Training und die Inferenz großer neuronaler Netze, Hochleistungsspiele und Aufgaben zur Erstellung von Inhalten wie Videobearbeitung und 3D-Rendering. Die umfangreiche Softwareunterstützung und die außergewöhnliche Rechenleistung prädestinieren die GPU für anspruchsvolle KI-Anwendungen, einschließlich Sprache-zu-Text-Transkription und Videobearbeitung. Wenn Ihr Budget es zulässt, können Sie auf die RTX 4090 aufsteigen, um noch mehr Leistung zu erhalten, oder mit einer RTX 3080 sparen, die immer noch eine beachtliche Leistung bietet. Aufgrund der hohen Stromaufnahme und der hohen Kosten eignen sich diese NVIDIA-GPUs jedoch eher für größere Desktop-Workstations.

Mit der RTX-Serie, die NVIDIA mit dem Slogan „the ultimate in ray tracing and AI“ bewirbt, ist im oberen Preissegment angesiedelt. Nachteilig kann sein, dass, wenn Sie sich kurz von Ihrer Workstation entfernen, das eine oder andere eifrige Kind im Haushalt Ihren Platz kapert, um den neuesten Ego-Shooter mit hohen FPS-Raten zu spielen, der auf diesen Biestern verfügbar ist.

Apple Chips der M-Serie

Diejenigen, die in das Apple-Ökosystem investiert haben, sollten wissen, dass der M1-Chip, der als Apples erster speziell für den Mac entwickelter Chip angepriesen wird, im Jahr 2020 eingeführt wurde. Der nachfolgende M2-Chip wurde 2022 auf den Markt gebracht, und beide verbinden KI-Beschleunigung direkt mit der CPU. Der M1-Chip verfügt über eine Neural Engine mit acht Kernen und eine Leistung von 11 TOPS, während der M2-Chip eine Neural Engine mit 16 Kernen und 15,8 TOPS bietet. Diese Chips sind in Geräten wie dem MacBook Pro und dem Mac Mini zu finden und bieten geräteinterne KI-Verarbeitung für Anwendungen wie Siri, Bildverarbeitung und Augmented Reality. Die nahtlose Integration in macOS und iOS macht diese Chips äußerst effizient für KI-Anwendungen im Consumer-Bereich, insbesondere für diejenigen, die im Apple-Ökosystem zu Hause sind.

M3, M3 Pro und M3 Max wurden 2023 angekündigt und sollen Verbesserungen auf der ganzen Linie erbringen. Die M3-Chips waren die ersten 3-Nanometer-Chips und verfügten über eine neue GPU-Architektur, die Geschwindigkeitsverbesserungen von bis zu 30 % beziehungsweise 50 % gegenüber dem M2 und M1 ermöglicht. Mit schnellerer CPU-Leistung, einer effizienteren Neural Engine und einer GPU-Architektur der nächsten Generation, die fortschrittliche Funktionen wie dynamisches Caching und hardwarebeschleunigtes Raytracing (Strahlenverfolgung) unterstützt, eignet sich die M3-Serie besonders gut für intensive Aufgaben wie High-End-Grafikverarbeitung, KI/ML-Workloads und komplexe Rechenaufgaben.

Die Tinte der M3-Ankündigung war kaum getrocknet, als Apple im Mai 2024 den M4-Chip ankündigte, aber dieser ist derzeit nur im iPad Pro des Unternehmens verfügbar. Es wäre interessant zu sehen, ob ein Drittentwickler einen Anwendungsfall findet, um ein teures iPad Pro für eine kommerzielle oder industrielle Aufgabe im Bereich des maschinellen Lernens einzusetzen.

Wenn Sie Ihre schweren Aufgaben in der Apple-Welt erledigen, werden Sie von einem MacBook mit einem M2- oder M3-Chip für Ihre KI-Anwendungen nicht enttäuscht sein. Welchen Chip Sie unter der Haube haben wollen und werden, hängt von Ihrem Budget und Ihrer Anwendung ab.

Eingebettet vs. PC-basiert: Welche Wahl ist die richtige?

Die Wahl zwischen eingebetteten und PC-basierten Edge-Computing-Lösungen hängt weitgehend von den spezifischen Anforderungen Ihrer Anwendung ab.

Eingebettete Edge-KI

- Am besten geeignet für: Echtzeitanwendungen mit geringem Strombedarf, bei denen Größe und Stromverbrauch kritisch sind, beispielsweise Smart Home-Geräte, Wearables und autonome Sensoren

- Vorteile: Geringere Stromaufnahme, kompakte Abmessungen, kostengünstig.

PC-basierte Edge-KI

- Ideal für: Anwendungen, die eine hohe Rechenleistung und Flexibilität erfordern, zum Beispiel Desktop-KI-Anwendungen, komplexe Datenanalysen sowie die Entwicklung und Prüfung von KI-Modellen

- Vorteile: Hohe Leistung, größere Flexibilität, Fähigkeit, komplexere Aufgaben zu bewältigen

Die Wahl ist keine Qual

Eingebettete und PC-basierte Edge-KI-Lösungen haben ihre spezifischen Vor- und Nachteile. Eingebettete Beschleuniger eignen sich perfekt für stromsparende Echtzeitanwendungen, während auf Workstation/Laptop basierenden Lösungen wie RTX-GPUs von NVIDIA und die M-Chipreihe von Apple eine hohe Leistung für anspruchsvollere Aufgaben bieten. Wenn Sie die Stärken und Grenzen der einzelnen Lösungen kennen, können Sie die richtige Lösung für Ihre spezifischen Anforderungen herauspicken und die Leistung der KI nutzen, um intelligentere, effizientere Systeme zu schaffen.

Dieser Vergleich ist keineswegs erschöpfend, aber er betrachtet einige der beliebtesten Edge-KI-Beschleuniger, die ich ausprobiert habe. Jeder hat seine Vor- und Nachteile - entscheidend ist, dass Sie den für Ihre Anwendung am besten geeigneten auswählen.

Der Artikel "2024: Eine Odyssee in die KI: Desktop Versus Embedded Beschleuniger"(230181-H-02), erscheint in Elektor September/Oktober 2024.

Diskussion (0 Kommentare)